NVIDIA H200 và GH200: Siêu chip AI thế hệ tiếp theo

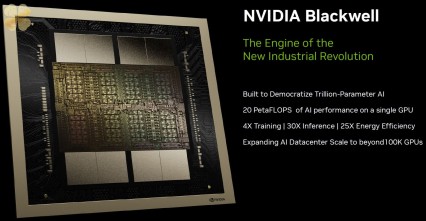

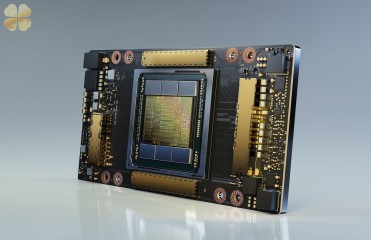

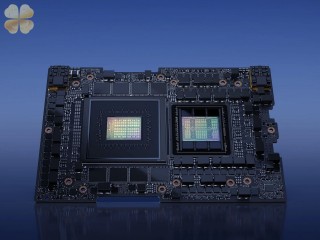

NVIDIA đã công bố các siêu chip thế hệ tiếp theo H200 và GH200, được thiết kế để cung cấp sức mạnh cho tương lai của siêu tính toán AI. Những chip mới này dựa trên kiến trúc Hopper H100 hiện có, mang lại những cải tiến đáng kể về dung lượng và băng thông bộ nhớ. H200 có 141GB bộ nhớ HBM3e, cung cấp băng thông tổng cộng 4,8TB/s cho mỗi GPU, trong khi GH200 kết hợp GPU H200 với CPU Grace, cung cấp tổng dung lượng bộ nhớ 624GB cho mỗi siêu chip.